Недавно один наблюдательный сотрудник стал свидетелем поразительной сцены. Старший разработчик в его компании потратил три часа, пытаясь справиться с DeepSeek — одним из самых продвинутых ИИ-инструментов на рынке.

Не просто работал, а боролся. И терпел неудачу.

Если кто-то до сих пор не знаком с DeepSeek, стоит обратить внимание: этот ИИ уже вплотную догоняет ChatGPT и Claude.

Разработчица, которую он наблюдал, вводила идеально составленные промпты, удаляла их и начинала сначала. Всё ради отладки простого React-компонента. Ситуация, знакомая многим. Но спустя несколько часов она вдруг прекратила печатать, достала телефон и… заговорила.

Просто проговорила вслух суть задачи.

Результат? Уже через две минуты DeepSeek выдал точный и полезный ответ.

Почему это работает: немного о мозге

Такое поведение кажется неожиданным, но за ним стоит вполне объяснимая нейрофизиология. Исследования, недавно опубликованные учёными Стэнфорда, проливают свет на происходящее.

Оказывается, при вводе текста в ИИ активируются те же области мозга, которые отвечают за формальную деловую коммуникацию. Проще говоря, мы подсознательно воспринимаем ИИ как начальника высшего звена. Пишем сухо, формально, обтекаемо — и, что самое главное, теряем до 62% контекста, который на самом деле знаем.

Мы не говорим с ИИ как с напарником. Мы будто отчитываемся перед директором.

И в результате:

- используем обезличенный, «роботизированный» язык,

- упускаем детали, важные для понимания,

- и оставляем за кадром ключевые нюансы, которые могли бы всё изменить.

Почему именно DeepSeek так страдает от этого

В том же эксперименте специально был протестирован DeepSeek.

Текстовый промпт:

«Help debug React useEffect infinite loop»

Ответ ИИ:

Общие советы, стандартные рекомендации, ничего нового — всё это легко можно найти на Stack Overflow.

Тот же запрос, но в устной форме:

«Привет. У меня тут useEffect сходит с ума. Он делает fetch юзер-данных, но, кажется, что-то в массиве зависимостей вызывает бесконечный цикл. Подозреваю, дело в обновлении состояния внутри, но не уверен. Самое странное — это происходит только когда…»

Результат:

DeepSeek сразу понял проблему.

Объяснил причину сбоя.

Предложил три варианта исправления.

Разница впечатляющая. Один и тот же ИИ, но голосовая подача дала в разы больше результата.

И дело не в том, что ИИ лучше работает с аудиоданными. Просто когда человек говорит, он невольно выражается яснее, подробнее и свободнее. В отличие от печатного текста, речь насыщена контекстом, интонацией и нюансами.

Как появилась идея решения

Проблема оказалась настолько раздражающей, что была разработана утилита AudioAI — изначально для внутреннего использования. Позже расширение стало доступно всем.

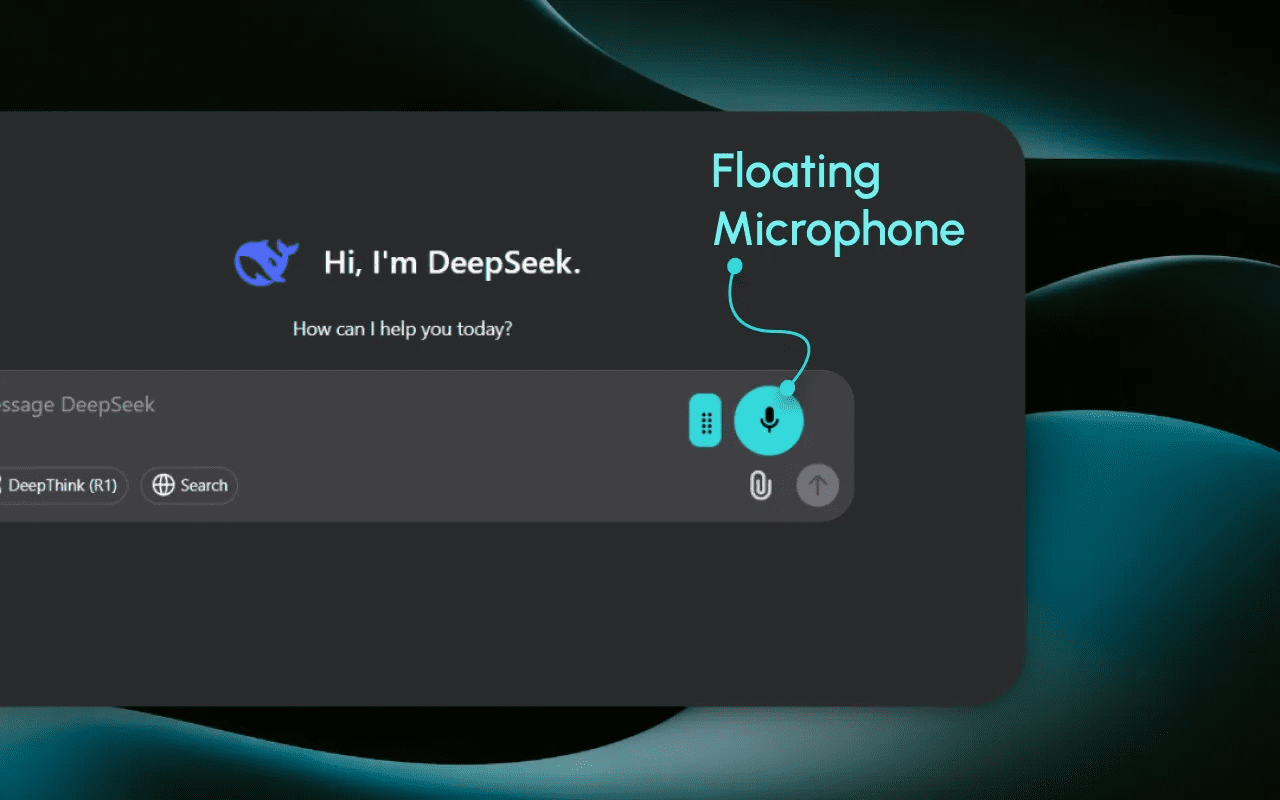

Это максимально простое расширение Chrome, которое добавляет кнопку микрофона на страницы:

- DeepSeek

- ChatGPT

- Claude

- Perplexity

- и другие браузерные ИИ-интерфейсы

Принцип прост: нажал кнопку, сказал вслух, получил качественный результат. Без танцев с бубном, переформулировок и угадываний «что же имелось в виду».

Также можно использовать встроенные средства:

- MacOS (два нажатия клавиши Control — и включается диктовка),

- Windows (сочетание Win + H).

Хотя качество встроенных распознавалок иногда оставляет желать лучшего, для многих пользователей этого вполне достаточно.

Что показали тесты: цифры впечатляют

В ходе полевых испытаний с участием более 300 пользователей, активно использующих DeepSeek и аналогичные ИИ-системы, были получены поразительные результаты.

72% участников отметили, что результаты стали лучше, если они формулировали запрос вслух, а не печатали его.

Оставшиеся 28% признались, что им просто неудобно говорить в голос в условиях опенспейса.

Один из участников эксперимента поделился такой историей:

«Я потратил два часа, пытаясь составить промпт для сложного SQL-запроса. Потом использовал AudioAI, объяснил голосом за пять минут — и получил нужный ответ с первого раза».

Простое упражнение: проверь сам

Для всех, кто работает с ИИ, предлагается попробовать следующее:

- Установить AudioAI — бесплатно, 10 минут в месяц хватит для начала.

(Или использовать встроенные голосовые инструменты Windows/MacOS.) - При следующем взаимодействии с ИИ:

- Сначала напечатать обычный промпт

- Затем проговорить тот же запрос вслух

- Сравнить результат

- И уже после — сделать выводы.

Выводы: время изменить подход

На календаре — 2025 год. Искусственный интеллект становится всё мощнее и точнее.

Но общаемся мы с ним так, словно всё ещё пишем формальные письма в офисе из 90-х.

Хватит.

Пришло время говорить с ИИ по-настоящему.

Не как с бездушным ботом, а как с разумным собеседником.

Результаты не заставят себя ждать.

Мозг начнёт работать легче.

А ИИ — точнее.

И исчезнут часы, потраченные на переписывание фраз и угадывание нужной формулировки.

Если нужно, могу также подготовить версию этого текста для лендинга, рассылки или соцсетей.

***✨ А что думаете вы? ✨

Делитесь мыслями в комментариях — ваше мнение вдохновляет нас и других!

Следите за новыми идеями и присоединяйтесь:

• Наш сайт — всё самое важное в одном месте

• Дзен — свежие статьи каждый день

• Телеграм — быстрые обновления и анонсы

• ВКонтакте — будьте в центре обсуждений

• Одноклассники — делитесь с близкими

Ваш отклик помогает нам создавать больше полезного контента. Спасибо, что вы с нами — давайте расти вместе! 🙌